ダムヤン スタムカー:共同研究プロジェクト(Sony RAP 2020)の概要について、特に現在の最先端技術との違いについて教えてください。

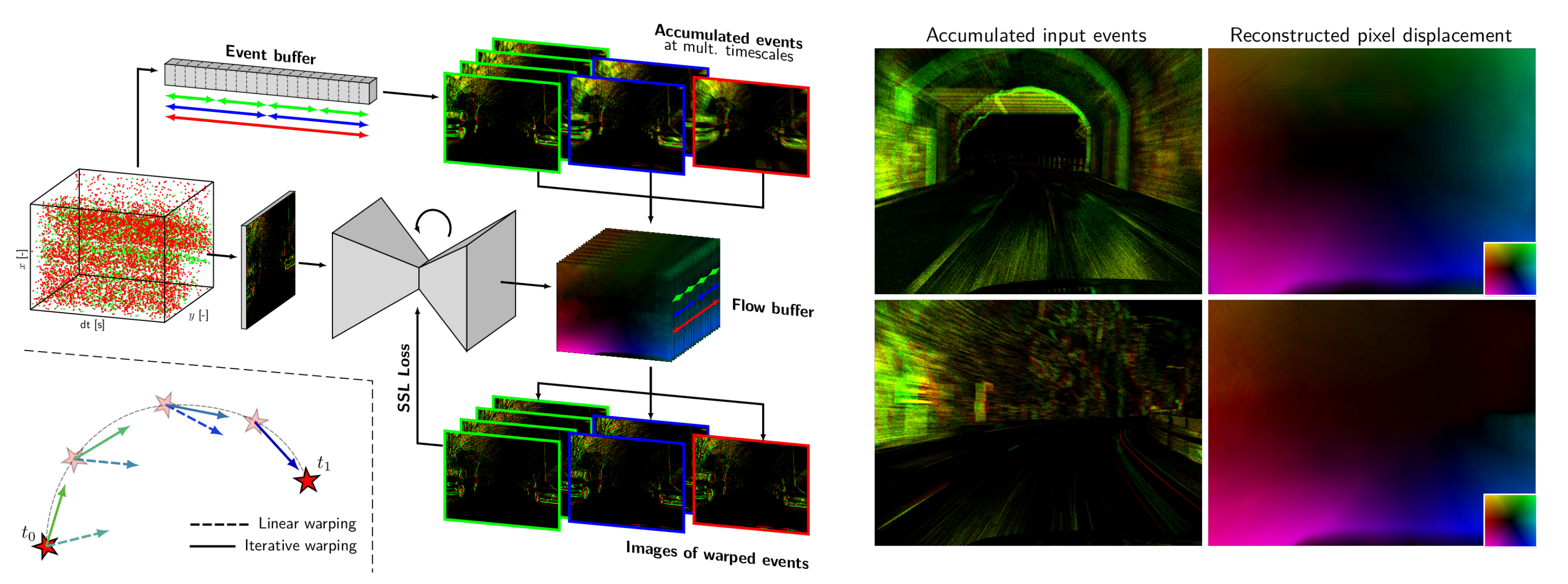

フェデリコ・パレデス・バジェス博士: イベントカメラは、複雑なコンピュータビジョンの問題に対する低レイテンシー・低消費電力ソリューションの新たな道を開くものとして、最近大きな注目を集めています。このようなソリューションを実現するためには、イベントデータのユニークな性質を活用できるアルゴリズムを開発する必要があります。しかし、現在の最先端技術では、フレームベースの研究の影響を強く受けており、そのような開発は進められていません。このソリューションは通常、比較的長い時間ウィンドウにわたってイベントを蓄積し、人工的な「イベントフレーム」を作成し、それを従来の(密な)機械学習アルゴリズムで処理します。今回のSony RAP共同研究においては、これを考慮し、高い推論頻度のモデルへのスケーリングを可能にする、イベントベースのオプティカルフローの逐次推定のための新しい自己教師あり学習パイプラインを提案しました。この中核の技術として、我々は入力イベントの非線形性や様々な統計量に対してロバストになる、連続的に実行されるステートフルニューラルモデルの使用を提案しています。このモデルは入力イベントの非線形性や様々な統計量に対してロバストになるように、コントラスト最大化の新しい計算式を用いて、イベントのスパースなセットからオプティカルフローを推定するように学習します。複数のデータセットにわたる結果から、本手法の有効性が確認され、正解データなしで訓練または最適化されたアプローチの精度という点で、新たな技術水準を確立しました。

図1: 我々のパイプラインは、イベントストリームの小さなパーティションをリカレントモデルで逐次処理することにより、イベントベースのオプティカルフローを推定します。我々は、反復ワーピングによるイベントカメラの高い時間分解能を利用して、正確なオプティカルフロー予測(右)を行うことができるマルチタイムスケールコントラスト最大化方式に基づく新しい自己教師あり学習フレームワーク(左)を提案しています。

このトピックに関する論文は、パリで開催されたICCV 2023会議で発表されました:

Taming Contrast Maximization for Learning

Federico Paredes-Vallés (1,2), Kirk Y. W. Scheper (2), Christope De Wagter (1), Guido C. H. E. de Croon (1),

(1) Micro Air Vehicle Laboratory, Delft University of Technology,

(2) Stuttgart Laboratory 1, Sony Semiconductor Solutions Europe, Sony Europe B.V.

その他の資料はこちらを参照してください: https://mavlab.tudelft.nl/taming_event_flow/

ダムヤン スタムカー:Sony RAPでのソニーの研究者との緊密なコラボレーションは、あなたの現在の研究の方向性にどの様なインパクトがありましたか?

フェデリコ・パレデス・バジェス博士:学位論文の一環としてSony RAPに参加したことは、産業界のパートナーとしてソニーと緊密に協力することができたという意味で、貴重な機会となりました。このコラボレーションにより、ソニーのカウンターパートであるカーク・シェッパー博士と直接コンタクトを取ることができ、建設的なフィードバックを求めることができ、大学の視点とは異なる視点を得ることができました。

Sony RAPのプロジェクトでは、四半期ごとの成果物が明確に定義されていました。作業明細書(SoW)は、業界の注目点や私の博士課程研究の目標に適合するよう調整しました。この体制により、生産的で目標志向の共同研究を推し進められました。

ソニーとの緊密な共同作業は、全体的に非常に良い経験であり、私の論文に大きな影響を与えました。その結果、私はこの共同研究を続けることにし、シュトゥットガルト第1研究所にリサーチエンジニア(現シニア)として加わりました。この職務では、イベントカメラデータを処理する効率的なアプローチとして、ニューロモーフィックコンピューティングの探求に取り組んでいます。

ダムヤン スタムカー:この研究では、イベントベースのカメラからのデータの処理に関しパラダイムシフトを提案していますが、今後このプロセスからどのようなユースケースが恩恵を受け、現実のシナリオに導入するためにはどのような課題を克服する必要があるのでしょうか?

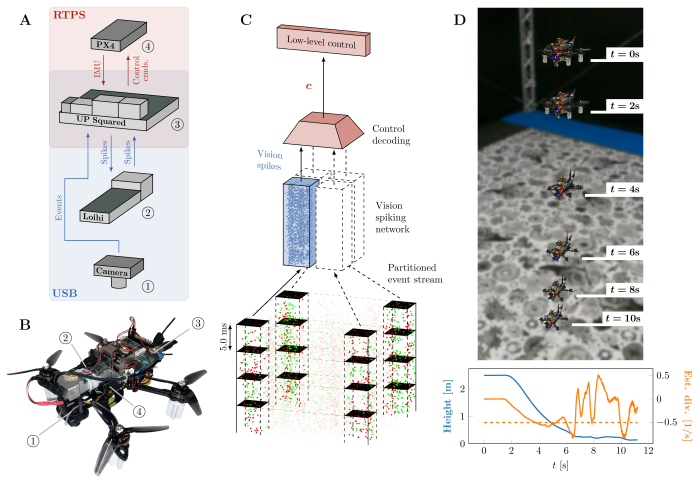

フェデリコ・パレデス・バジェス博士: 私たちの研究では、イベントベースのカメラ向けの低消費電力および低遅延ソリューションの開発における方針の変更を提案しています。蓄積されたイベントのフレームとステートレスなニューラルネットワークアーキテクチャを組み合わせる代わりに、再帰型ニューラルネットワークに焦点を当てることを提唱しています。このネットワークは、イベントストリームのスパースさにもかかわらず、データをより速く処理できます。今回のソニーとの共同研究プロジェクトで提案するアプローチは、特にニューロモーフィックコンピューティングにおける将来の研究への道を開くものです。ニューロモーフィックハードウェア上のスパイキングネットワークは、イベントカメラの利点を活用できますが、入力イベントを到着後すぐに処理する必要があります。私たちが提案するフレームワークは、オプティカルフローの推定をほぼ連続的に行い、すべての情報統合をモデル内で行うことができ、この目標に向けた第一歩を踏み出すことができました。この技術の潜在的な応用例には、自動車領域での使用や、低消費電力のロボティクス(例えば小型自律飛行ロボット)向けのエッジデバイスのコンピュータビジョンなどがあります。その後の研究で、私を含むデルフト工科大学のチームは、ニューロモーフィックプロセッサ上にこのアルゴリズムのスパイキングバリエーションを実装し、小型飛行機に搭載しました。以下の論文で示されているように、私たちは200 Hz以上のオプティカルフローベース、ビジョンベースのナビゲーションを、電力消費わずかアイドル時0.95 W、ソリューション実行時追加7〜12 mWで実現しました。しかし、このソリューションの導入には、主にイベントデータを処理するニューロモーフィックハードウェアに起因する複数の課題があります。この技術はまだ初期段階であるため、計算リソースに関して厳しい制限の中で動作させなければならず、イメージ空間の角にのみ視野を制限する必要もあり、また精度にも影響しました。この分野が進歩するにつれて、ニューロモーフィックプロセッサはより強力になり、最終的には従来のニューラルネットワークアクセラレータと同等の性能を、何分の1かの消費電力で実現できると予想しています。

図2: 提案システムの概要。(A)本研究で使用したクアッドローター(総重量1.0kg、先端から先端までの直径35cm)。(B)イベントカメラ、ニューロモーフィックプロセッサ、シングルボードコンピュータ、フライトコントローラ間の通信を示すハードウェアの概要。 C)入力としてのイベント、ビジョンネットワークによる処理、および制御コマンドへのデコードを示すパイプラインの概要。(D)オプティカルフローダイバージェンス着陸用システムのデモンストレーション。

Fully neuromorphic vision and control for autonomous drone flight

Federico Paredes-Vallés, Jesse J. Hagenaars, Julien D. Dupeyroux, Stein Stroobants, Yingfu Xu,

Guido C. H. E. de Croon, Micro Air Vehicle Laboratory, Delft University of Technology,